来源:倍可亲(backchina.com)

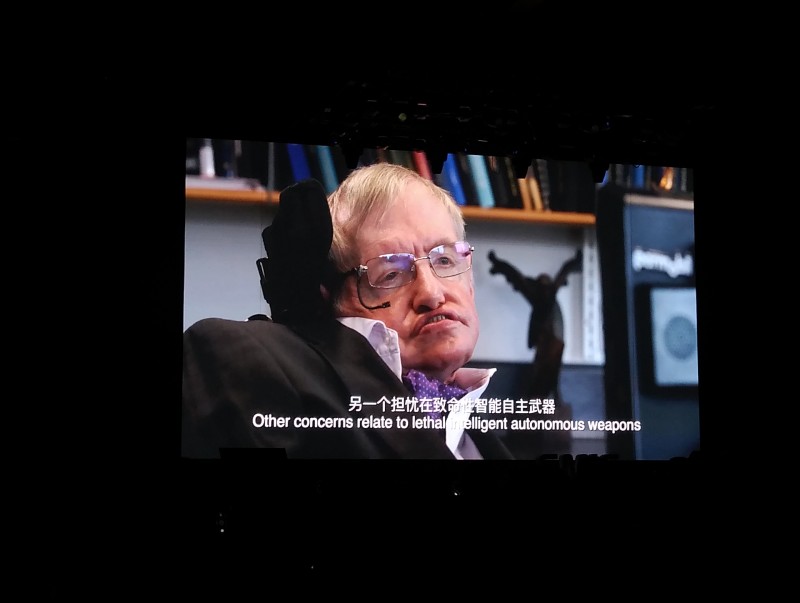

霍金

4月27日消息,GMIC北京2017在北京召开,来自英国的著名科学家斯蒂芬·霍金教授通过视频发表演讲,谈了他关于人工智能的看法,他认为人工智能在未来是否会威胁到人类还不好说,现在我们就该从研究中规避这种风险。

霍金认为,人工智能的崛起是人类历史上最好的事情,也有可能是最糟糕的,但它是最好的还是最坏的,现在还不能确定。

人工智能的出现是一种必然的趋势。从实验室研究到实现人工智能的经济效益,有很长的路,哪怕很小的提升,也可以实现巨大的效益。我们现在的工作应该从提升人工智能的能力转化为提升人工智能的社会效益。

我们现在对于人工智能的研究是从各个分支入手,比如语音识别,图像分类,自动驾驶,机器翻译,步态运动等,推动人工智能的快速发展。但是就长远来说,人脑和计算机能实现的事情,是没有本质区别的。

现在更需要关注的是,包括人工智能的研究人员也在担心和探索人工智能的伦理问题。拿机器人来说,我们需要在未来确保机器人一直都会为人类工作。未来可能机器人会需要人格化的身份,就像今天的独立法人,为了确保人类可以控制机器人,研究和设计人员都应该确保每个机器人都有终止开关。

人工智能可以解决世界上的大部分问题,包括人类的疾病、社会的问题等,AI有这个潜力。如果对于AI的部署得当,那将会挖掘无限的潜力,如果部署不当,可以威胁人类的生存。人工智能一旦脱离控制,人类受到进化的限制,将无法与之竞争。跟据霍金的预测,在未来一段时间内,AI将迅速地消灭数百万的工作岗位。

更长远的担忧就是人工智能系统失控的风险以及超级智能的崛起。人工智能赢得围棋就是这种未来的趋势,人工智能未来的潜力在于,我们现在取得的成就和未来几十年的相比,简直是相形见绌,未来人工智能甚至有可能终结人类文明。

我们如何去研究人工智能,是解决和理解这个问题的关键。我们需要在研究过程中就规避这种风险。霍金表示,他曾经和埃隆·马斯克有过一次谈话,并且联合科学家们签署一份关于人工智能的协议,发表了一封公开信——《为稳定人工智能并从中获益的公开信》。他还在伦敦建立了一个新的研究中心——利弗姆休研究中心。霍金还呼吁,我们需要确保下一代继续参与科学研究,以继续发挥科学的潜力。